在这个全新的时代,机器人智能化的背后功能也黑科技比你想得要多多。

计算机科学和密码学的先驱艾伦麦吉森图灵(Alan mathison turing)在1950年写下了《计算机器与智能》这篇文章,提出了一个经典的测试:如果一台机器与人类对话,并且超过30%的测试表明人类错误地认为自己在与人类而不是机器对话,那么这台机器可以说是智能的。这就是人工智能界众所周知的“图灵测试”。图灵在20世纪末就预言计算机会通过这项测试,但实际上直到2014年,人工智能软件尤金古斯曼(Eugene Gustmann)才第一个通过图灵测试。这也从侧面反映了一个事实:虽然科学家们在70多年前就已经做出了猜测,但要赋予机器人“灵魂”,仍然任重道远。那么问题来了。目前,人工智能正处于一个相对高速发展的阶段。我们能做些什么来让机器人与我们互动?

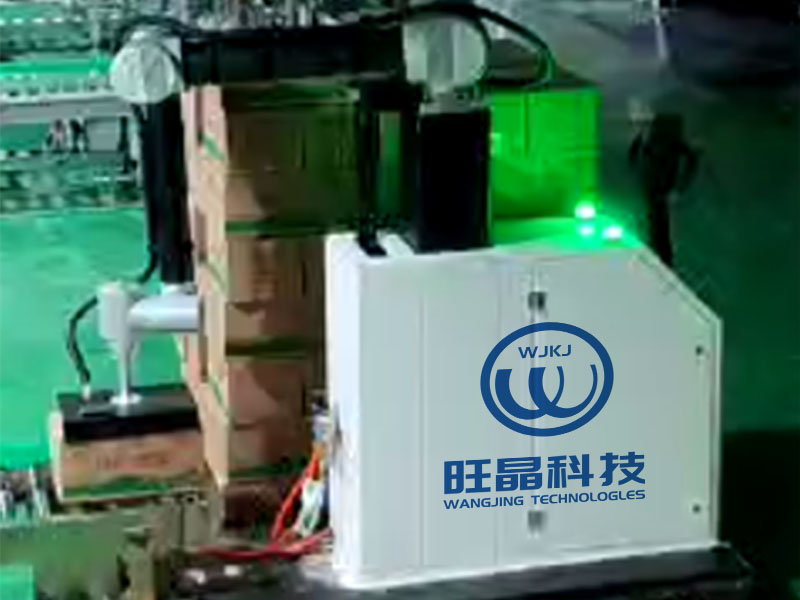

装货.

让机器人作为地球上最聪明的生物“看”世界。人类获取信息的渠道83%来自视觉,11%来自听觉,3.5%来自嗅觉,1.5%来自触觉,1%来自味觉。既然要模拟人类的思维方式,其核心就是通过深度学习,让机器根据收集到的数据信息做出相应的反馈。考虑到我们的大部分信息来自视觉,

装货.

工厂里最常见的机器人也有丰富的感官传感器。目前,随着人工智能视觉技术的不断演进,包括物体识别、目标跟踪、导航和避障,已经成为各类智能设备的前端共性技术。我们可以在工业生产自动化、流水线控制、自动驾驶、安防监控、遥感图像分析、无人机、农业生产、机器人等领域找到很多案例。比如上海人工智能研究所研发的核酸采样机器人,通过视觉传感器识别人脸的位置和张口动作是否符合采样要求。机械臂将棉签伸入口腔后,利用内窥镜视觉系统检测口腔环境,识别扁桃体并引导棉签采集扁桃体附近的分泌物。力控传感器可以实时反馈力控数据,将机械臂的力控制在安全阈值内,在22秒左右完成一次无人核酸采样。这是典型的依靠环境感知的自动机器人。

结合视觉和触觉传感器,核酸采样机器人可以完成无人采样任务。对于移动机器人来说,需要使用各种不同的传感器来实现环境感知。例如,你可能会在餐馆看到自动送餐机器人,或者在工厂常见的运输机器人。它们可以通过配备激光雷达、立体摄像机、红外和超宽带传感器来“辨别”环境和构建地图,因此它们具有识别、感知、理解、判断和行动的能力。感知环境的能力是机器人最基本的功能,也就是说这类机器人更适合服务型的工作。目前,这种机器人还可以完成对人的异常行为进行监控、对人进行探测和记录、对异常高温或火灾进行报警、对异常环境数据进行报警等功能。通过模块化设备,甚至通过远程监控模块,它们可以代替人进入危险场所,完成勘察任务。让机器人“说话”。如果只是通过环境感知来完成工作,这样的机器人“聪明”吗?从人类的角度来看,它们都是自动化的工具,和我们在电影中想象的智能机器人有非常明显的差距。其实造成这种感觉的原因很大程度上是因为大部分服务机器人无法与人互动,而我们人类互动的核心方式就是说话聊天。70多年前提出的图灵测试,至今仍以书面形式验证。现在如果要重新定义,语音交互应该是必选项。比尔盖茨曾说过“人类与自然的认知习惯和交流形式,一定是人机交互的发展方向”。

看似简单的对话,却包含了许多分析步骤。人机交互技术主要包括语音识别、语义理解、人脸识别、图像识别、体感/手势交互等。其中,语音人机交互的过程包括信息输入输出、语音处理、语义分析、智能逻辑处理以及知识和内容的整合。目前人工智能语音技术可以分为近场语音和远场语音。近场语音基本用来满足一些辅助需求。比如苹果Siri和微软萧冰都是近场语音产品吗?很多智能音箱都可以实现远场语音,用户可以在5米外通过语音指令它控制智能家居设备。这些看似简单的任务,其实需要很高的准确度。从处理的角度来说,首先要通过声学对我们的声音和周围的环境进行处理,然后通过语音识别技术把我们听到的声音翻译成文字,再通过语义理解技术分析这些文字的意思。最后,机器执行用户的指令或者通过语音合成技术把要表达的内容合成为语音。

机器人的语义理解能力目前还处于较低水平。然而,在现实环境中,由于噪音等环境因素,机器仍然无法完全准确地识别自然语言。当机器把听到的语音翻译成单词时,重音、口音模糊、语法模糊都会影响成功率。而且人类的语言太复杂,受词界歧义、一词多义、句法歧义、语境理解的影响。另外,汉语中有大量的方言,所以语义理解是一个巨大的障碍。所以目前的人工智能语音系统更多的是用在垂直使用场景,比如车载智能语音系统、儿童娱乐教育软件、人工智能客服等等。尤其是人工智能客服,很多人应该都接到过银行或者金融机构的智能客服电话。在大多数情况下,它的性能与真人相差不大,但严重缺乏灵活性,只能在相对狭窄的范围内进行通信,准确性不高。但一方面可以实现对客户需求的快速响应,另一方面也可以在一定程度上节省时间和人力成本,所以未来一定会随着渗透率的加深而不断演进。让机器人变得更聪明既然我们已经谈到了机器人的智能进化,有些读者可能会问:它是如何进化的?最广为人知的方法是深度学习。早在2011年,谷歌一个实验室的研究人员就从视频网站中提取了1000万张静态图像,“喂”给谷歌大脑,目的是找到重复的图像。谷歌大脑花了三天时间完成了这项挑战,谷歌大脑是由1000台计算机和16000个处理器组成的10亿个神经单元深度学习模型。

机器人抓取姿态判别的深度学习概念来源于人工神经网络的研究。本质上就是构建一个多隐层的机器学习架构模型。通过对大规模数据进行训练,可以获得大量更具代表性的特征信息,从而对样本进行分类和预测,提高分类和预测的准确性。比如抓取姿势辨别,对于人类来说,只需要看几眼就能知道用什么手势去拿东西,但是对于机器人来说,这是一个很大的挑战。涉及的研究内容包括智能学习、抓取姿态判别、机器人运动规划与控制等。而且还需要根据被抓取物体的材料属性来调整抓取姿势和力度。但是,创建一个强大的神经网络需要更多的处理层,需要强大的数据处理能力,所以深度学习往往有上游硬件大佬做后盾。近年来图形处理器、超级计算机和云计算的快速发展使得深度学习脱颖而出,英伟达、英特尔、AMD等芯片巨头都站在了人工智能学习舞台的中央。深度学习技术是基于大量的例子。从中学习的数据越多,它就越聪明。因为大数据不可或缺,目前拥有大数据量的IT巨头,如Google、微软、百度等。在深度学习方面做的最好。同时,深度学习技术在语音识别、计算机视觉、语言翻译等领域优于传统的机器学习方法。甚至在人脸验证和图像分类上超越了人类的识别能力。比如短视频时代流行的人工智能“换脸”,就是将原始视频中的人脸逐帧导出,然后通过大量待替换的人脸照片进行模型训练。在训练过程中,你会直观地看到被替换的人脸从模糊逐渐变得清晰。根据电脑配置的不同,经过几个小时甚至几十个小时的训练,你可以得到一个相当不错的替换结果。这就是深度学习的典型过程。

姿态识别也是机器人视觉学习的重点之一。对于机器人来说,深度学习除了图像识别还有很多应用,比如工业或安防机器人需要的复杂环境下的路线规划和室内导航,教育机器人识别学生坐姿、举手、跌倒的姿势判断等。未来计算方式可能会倾向于与大数据、云计算相结合,让机器人利用云平台更好地存储资源,自主学习。同时,在大数据环境下,大量机器人共享分享学习内容,叠加学习模型,更有效地分析处理海量数据,从而提高学习和工作效率,开发智能机器人的潜力。当然,这些发展中还隐藏着许多问题。比如机器人与云平台结合,由于技术还不够成熟,资源分配、系统安全、可靠有效的通信协议、如何突破上游各大厂商之间的技术壁垒,都是下一步研究需要关注的问题。